在2024年的AI领域,Meta发布的Llama 3.1模型无疑成为了研究者和开发者的新宠。我有幸通过魔乐社区提供的资源,对这一模型进行了深入的学习和实践。在这个过程中,魔乐社区的资源和支持给我留下了深刻的印象。

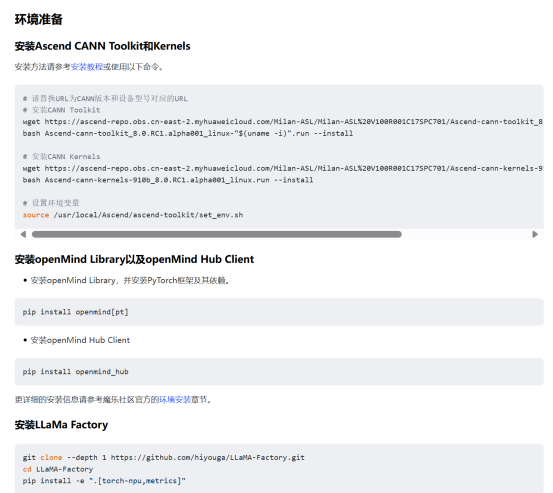

环境准备的便捷性

魔乐社区提供的实践指导非常详尽,从安装Ascend CANN Toolkit和Kernels到openMind Library以及openMind Hub Client的安装,每一步都有清晰的命令和说明。这大大简化了环境搭建的过程,即使是对于新手来说,也能够快速上手。

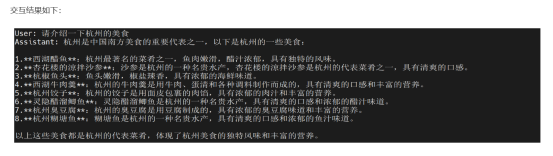

模型下载与推理的直观体验

通过魔乐社区提供的链接,用户能够轻松下载Llama 3.1模型,并使用openMind Library和LLaMa Factory进行模型推理。实践指导中的示例代码和配置文件非常直观,让用户能够快速理解并应用到自己的项目中。特别是推理结果的展示,也让用户对模型的能力有了直观的认识。

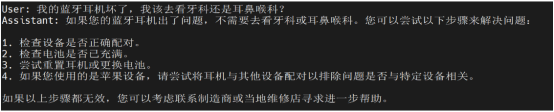

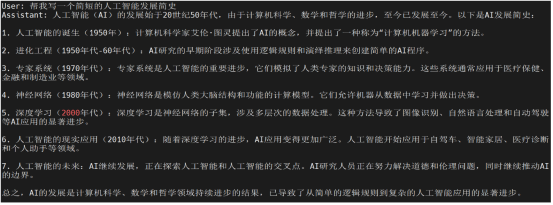

微调过程的详细指导

微调部分的指导同样详细,根据指引,可以直接引入社区内的 [DPO-En-Zh-20k数据集](感谢社区开发者在魔乐社区贡献的DPO-En-Zh-20k数据集),使用Git将数据集下载至本地。根据指引的命令进行了微调,微调完成后,Llama 3.1 PyTorch模型的中文能力有一定提升,以下为部分微调结果:

从数据集的下载到微调配置文件的编写,再到微调命令的执行,每一步都有详细的说明和示例,让我对模型微调有了更深入的理解,也提升了对模型微调的成功率。

结语

总的来说,魔乐社区的体验是积极的。它不仅提供了高质量的技术资源,还有着良好的社区氛围和支持。通过这次Llama 3.1模型的微调实践,我不仅学习到了很多知识,也对AI领域有了更深的认识。期待未来在魔乐社区(https://modelers.cn)中探索更多的技术和项目。